和AI网聊10分钟被骗430万,真实诈骗案震惊全网!官方:AI诈骗成功率接近100%

2023-05-23

渥太华微生活

来源:量子位

相关链接:

防不胜防,10分钟就被AI骗走430万!

这是这两天震惊全网的真实诈骗案件。

据包头警方发布,一公司老板接到朋友的微信视频电话,由于长相和声音确认都是“本人”,他丝毫没有怀疑就把钱打了过去。

结果一问朋友,对方根本不知道此事。这人才知道,原来诈骗者DeepFake了他朋友的面部和声音。

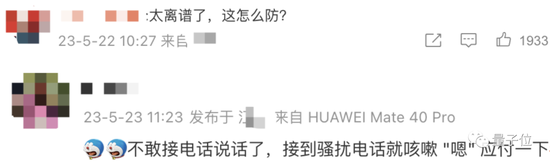

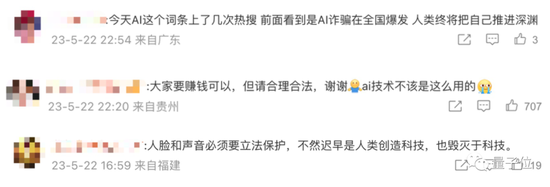

消息一出,直接冲上热搜第一。网友们纷纷表示:离大谱啊!不敢接电话了。

也有人提出质疑:AI这么好训练?这需要掌握个人的大量信息吧。

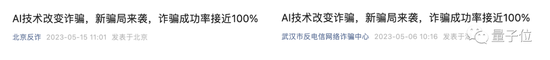

不过,虽说是看上去离谱的小概率事件,但据相关统计,AI技术新骗局来袭后,诈骗成功率竟接近100%。

毕竟连那些直播卖货“杨幂”“迪丽热巴”、B站歌手“孙燕姿”“林俊杰”都不是真的。

△图源抖音@娱乐日爆社,疑似直播间用杨幂的AI换脸带货

10分钟被AI骗走430万

据微信号平安包头介绍,一个月前,福州市一科技公司法人代表郭某,突然接到好友的微信视频。

聊天过程中,这个“好友”透露,自己朋友在外地投标,需要430万保证金,且公对公账户过账,所以想用郭某公司的账户走一下账。

背景介绍之后,“好友”就找郭某要了银行卡号,而后甩出一张银行转账底单的截图告诉郭某,已经把钱打到了郭某的账户上。

结果因为已经视频聊天以及各种“物证”,郭某并没有过多怀疑,甚至也没去核实钱款是否到账。

几分钟之后郭某就分两笔将钱打了个过去,本想去跟好友报备一下:“事情已经办妥”。

然而,好友缓缓打出来一个问号。

好在郭某反应比较快,第一时间报警。于是在警方和银行联动下,仅用时10分钟就成功拦截了330多万元被骗资金。

有网友表示,AI正成为骗子高手新一代工具。

还有网友调侃道,我没钱,哪个都骗不了我。(等等,好友有钱也不行doge)

而在这起案件背后,核心涉及了AI换脸以及语音合成这两个技术。

大众所熟知的AI换脸方面,现在即便一张2D照片,就能让口型动起来。据此前新华每日电讯消息,合成一个动态视频,成本也仅在2元至10元。

当时涉案嫌疑人表示:“客户”往往是成百上千购买,牟利空间巨大。

至于面向更精准、更实时的大型直播平台,视频实时换脸的全套模型购买价格在3.5万元,而且不存在延迟、也不会有bug。

至于像语音合成方面,技术效果也是越来越逼真,新模型和开源项目涌现。

前段时间,微软新模型VALL·E炸场学术圈:只需3秒,就可以复制任何人的声音,甚至连环境背景音都能模仿。

而具备语音合成功能的工具Bark,更是曾登顶GitHub榜首,除了声色接近真人,还能加入背景噪音和高度拟真的笑声、叹息和哭泣声等。

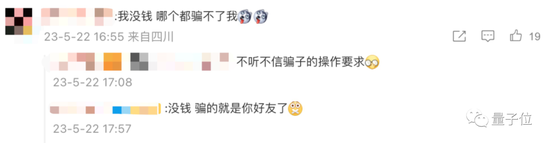

在各类社交网络上,各种小白教程也层出不穷。

要是结合虚拟摄像头,可能就更加防不胜防。

只需一个软件应用程序,就可以在视频通话中使用任意视频资源。

△图源微博@哑巴

点击接通后,对方完全不会看到播放、暂停视频等具体操作,只会看到视频播放的效果,“接通后看到的就是美女了”:

△图源微博@哑巴

这样一来,不仅视频可以通过虚拟摄像头,随意拍摄甚至更换,甚至连说话方式都可以真人定制:

△图源微博@哑巴

核心技术门槛的降低,也就给了犯罪分子可乘之机。

AI新骗局成功率接近100%

事实上,AI加持下的新型网络诈骗,并不止这一种操作。

无论是国内还是国外,都有不少用AI换脸的诈骗案例,小到在网络购物、兼职刷单等方面骗点小钱,大到冒充客服、投资理财人员等身份,获取银行卡账号密码直接转一大笔账,都有出现。

在国内,据南京警方消息,此前就出现过一起被QQ视频AI诈骗3000元的案例。

当事人小李表示,自己的大学同学小王通过QQ跟自己借3800元,称自己很着急,因为表姐住院了。

小李怀疑了小王的身份,而小王很快给她传来了一个4~5秒左右的动态QQ视频,不仅背景在医院,而且还打了声招呼。

这让小李打消了疑虑并转了3000元,然而随后发现对方已经将她删除拉黑,发现视频原来是AI伪造的。

目前包括北京反诈、武汉市反电信网络诈骗中心等官方公众号平台,都警告了AI技术新骗局的严重性,甚至表示“诈骗成功率接近100%”。

可别以为这些诈骗现象只在国内出现,国外的语音诈骗同样花样百出。

一种方式是用AI合成语音骗取电话转账。

据Gizmodo介绍,英国最近就同样发生了一起涉及金额高达22万英镑(折合人民币约192.4万元)的诈骗案件。

一位当地能源公司的CEO,在不知情的情况下被骗子“DeepFake”了自己的声音。随后,骗子用他这段声音,电话转账了22万英镑到自己的匈牙利账户。

据CEO表示,他后来自己听到这段AI合成语音时都惊讶了,因为这段语音不仅模仿出了他平时说话的语调,甚至还带有一点他的口癖,有点像是某种“微妙的德国口音”。

另一种则是用合成语音冒充亲友身份。

据nbc15报道,美国一位名叫Jennifer DeStefano的母亲,最近接到了一个自称是“绑匪”的诈骗电话,对方称劫持了她15岁的女儿,要求这位母亲交出100万美元的赎金。

电话那头传来了女儿的“呼救声”,不仅声音、就连哭声都非常相似。幸运的是她的丈夫及时证明了女儿是安全的,这次诈骗才没能成功。

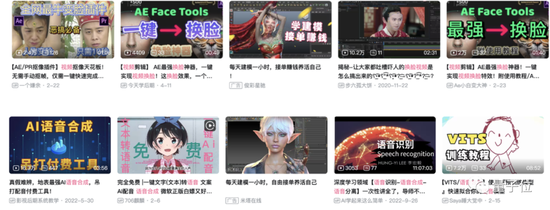

现在,不仅是诈骗,在AI技术加持下,就连杨幂、迪丽热巴们都在今天引发了热议。

原来,这是商家们想出的新“搞钱之道”,那就是在直播的时候,用AI换脸等技术“Deepfake”一下杨幂、迪丽热巴、Angelababy等明星的脸,这样大家就会误以为是明星本人在带货,从而拉升直播流量。

然而,这类行为目前还不能被直接判定为侵权。据21世纪经济报道,北京云嘉律师事务所律师赵占领表示:

平台对于平台内商家的侵权行为不承担直接侵权的责任,而是否构成帮助侵权,主要是看平台对于商家的侵权行为是否属于明知或应知。

但对于如何判定平台对用户、权利人的投诉是否明知或应知,在一般情况下很难认定。

显然,在AI技术越来越火热的当下,相关法律也还需要进一步完善。

One More Thing

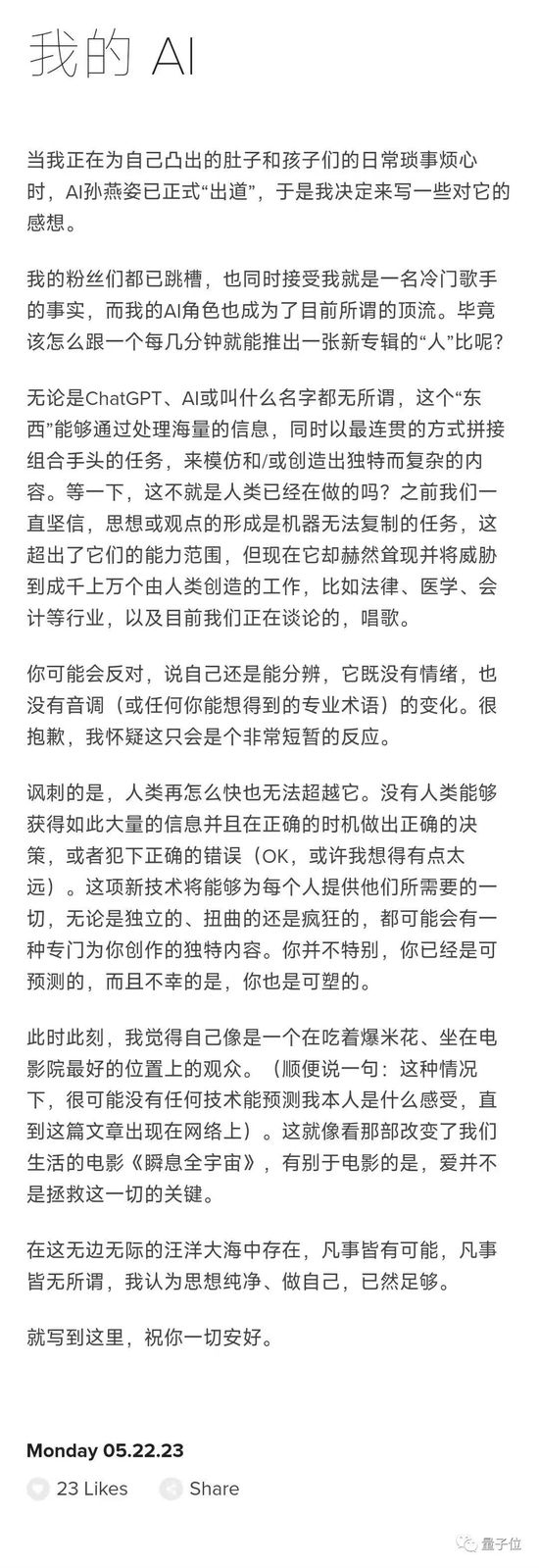

就在昨天夜里,最近火爆全网的“AI孙燕姿”本人,也就是歌手孙燕姿,出来回应了。

她发布了一篇名为《我的AI》的英文版文章,这是她团队的中文翻译全文:

然后,网友们看到后的评论是酱婶的:

△图源微信@南方都市报

| 全部评论 (2) |

|---|

| 匿名天使 发表评论于:2023-05-23 21:05:29 |

| 以后只记住,借钱没有,扫脸小心,手机不绑大额账户。 |

| 匿名天使 发表评论于:2023-05-23 21:05:20 |

| 不是为人类造福,可能造成社会大动荡。 |